Einleitung

Dieser KB-Artikel zeigt die Einrichtung einer lokalen KI-Schnittstelle mit Ollama. Dieses kann bspw. in einem combit CRM-Script verwendet werden. Wie das aussehen kann, finden Sie in unserem KB-Artikel Nutzung von KI-Features in combit CRM.

Systemanforderungen

(Quelle: docs.ollama.com)

- Betriebssystem: Windows 10 22H2 oder neuer, Home oder Pro

- NVIDIA-Treiber 452.39 oder neuer (falls Sie eine NVIDIA-Grafikkarte nutzen)

- AMD Radeon-Treiber: Drivers and Support for Processors and Graphics (falls Sie eine Radeon-Grafikkarte nutzen)

- Ollama verwendet Unicode-Zeichen für Fortschrittsanzeigen. In älteren Terminal-Schriftarten von Windows 10 können diese als unbekannte Kästchen dargestellt werden. Falls dies auftritt, ändern Sie die Schriftarteinstellungen Ihres Terminals.

Anleitung: Herunterladen und Installieren von NVIDIA-Treibern

- Website besuchen: – Rufen Sie die folgende URL auf: Treiberdetails | NVIDIA.

- Treiber herunterladen: Laden Sie die entsprechende Installationsdatei herunter.

- Installation starten: Doppelklicken Sie auf die heruntergeladene Datei und folgen Sie den Anweisungen des Installationsprogramms. Wählen Sie dabei die empfohlenen Einstellungen oder passen Sie diese nach Bedarf an.

- Abschluss: Starten Sie Ihren Computer neu, um sicherzustellen, dass die Treiber korrekt installiert wurden.

Anleitung: Installation und Verwendung von Ollama unter Windows

- Ollama herunterladen: Besuchen Sie die Website Download Ollama on Windows. Klicken Sie auf

Download.Hinweis: Ollama ist eine Drittsoftware. Es wird keine Haftung für etwaige Probleme durch die Installation übernommen. Stellen Sie sicher, dass Sie sie nur aus der offiziellen Quelle herunterladen.

- Installation: Doppelklicken Sie auf die Datei

OllamaSetup.exeund folgen Sie den Installationsanweisungen des Programms.

Verwendung über das GUI

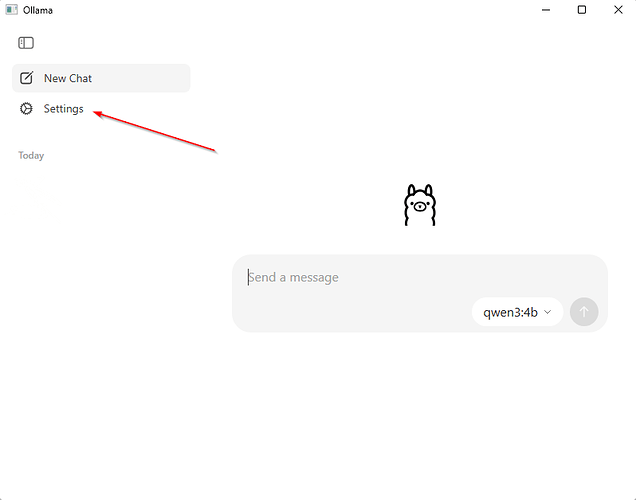

1. In die Einstellungen wechseln

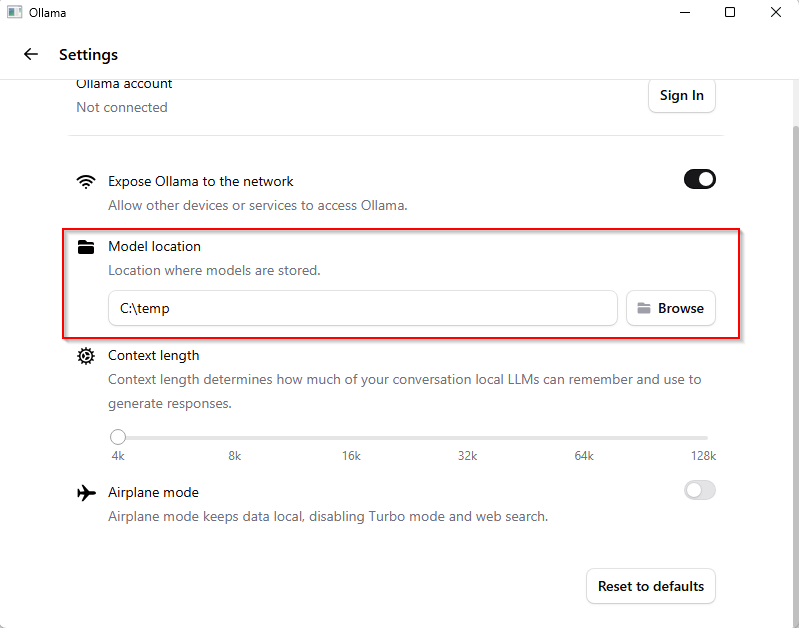

2. Speicherort für die Modelle festlegen

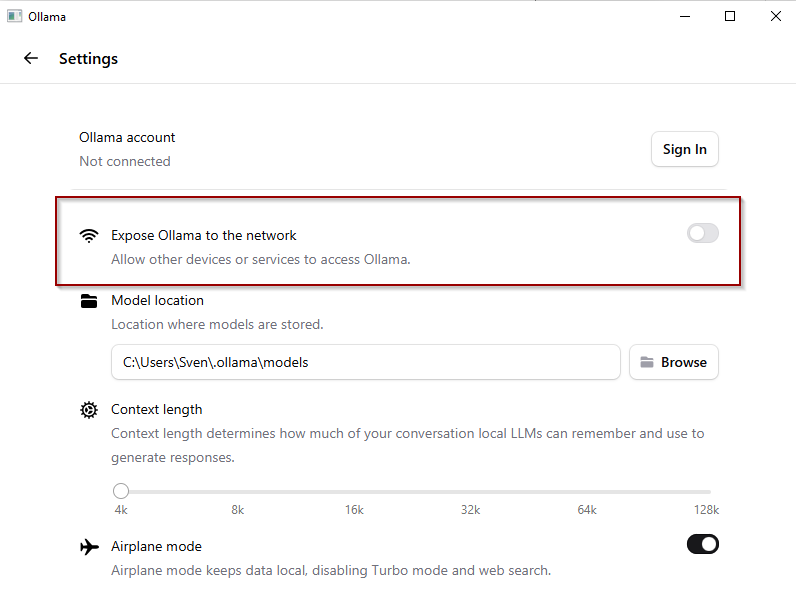

3. Netzwerkzugriff aktivieren

Hinweis: Es wird eine Änderung in der Windows-Firewall vorgenommen.

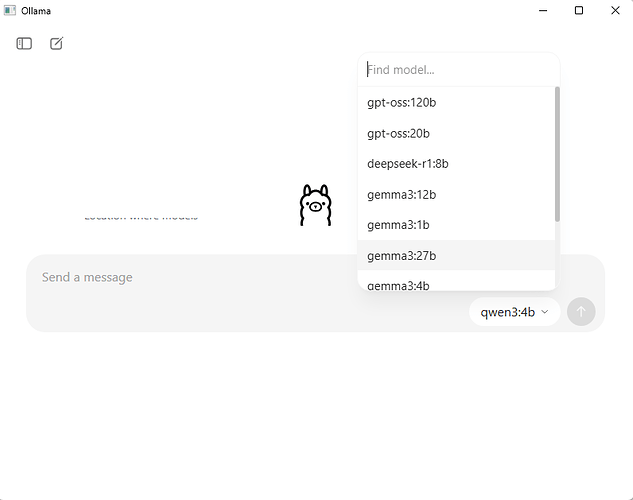

4. Modelle auswählen und installieren

Über das Drop-Down-Menü lassen sich direkt eine Reihe von interessanten Modellen auswählen.

Liste aller verfügbaren Modelle: Ollama

Aktuelle Empfehlungen für Zusammenfassungen:

| Modell | Hinweise | Kürzel für Aufruf und Download/Installation |

|---|---|---|

| Google Gemma 2 | Nur für kurze Texte geeignet, die zusammengefasst werden sollen | gemma2:9b |

| Google Gemma 3 | Auch für längere Texte geeignet | gemma3:12b |

| Llama 3.1 | Auch für längere Texte geeignet | llama3.1:8b |

| Llama 3.2 | Auch für längere Texte geeignet | llama3.2:3b |

| Llama 3.3 | Auch für längere Texte geeignet | llama3.3 |

Bei der Auswahl der Modelle sollte beachtet werden, ob der verwendete Computer über ausreichend Arbeitsspeicher (bzw. RAM und Video-RAM (VRAM)) verfügt.

Für 7B-Modelle sollten mindestens 8 GB RAM zur Verfügung stehen, für 13B-Modelle mindestens 16 GB und für 33B-Modelle mindestens 32 GB. Noch größere Modelle eignen sich aufgrund der sehr langen Antwortzeiten nicht. Der Download in das zuvor ausgewählte Verzeichnis beginnt nach Eingabe einer Nachricht in das Chat-Fenster automatisch.

Jeden Monat erscheinen neue oder aktualisierte Modelle, die in der Regel mehr leisten bei weniger VRAM-Verbrauch. Ein guter Indikator ist die hier angezeigte Reihenfolge und die Anzahl der Downloads pro Modell: library. So sind z. B. deepseek-r1:8b und gemma3:4b interessante Neuerscheinungen, die wir noch nicht testen konnten.

5. Airplane Mode

Neu in Ollama: Für eine rein lokale Nutzung sollte diese neue Option aktiviert werden. Nur im aktivierten Airplane Mode bleibt alles vollständig lokal. Der Turbo Mode (kostenpflichtig) und die Websuche (kostenpflichtig) werden dabei automatisch deaktiviert.

(Optional für Administratoren) Einstellungen über Umgebungsvariablen setzen

1. Kommandozeile öffnen

Unter Windows 10 drücken Sie die Tastenkombination Windows-Taste + R, geben Sie cmd ein und drücken Sie Enter, unter Windows 11 klicken Sie mit der rechten Maustaste auf das Startmenü und wählen Terminal oder Eingabeaufforderung.

2. Speicherort für Modelle ändern

Um den Speicherort zu ändern, müssen Sie die Umgebungsvariable OLLAMA_MODELS in Ihrem Benutzerkonto festlegen. Gehen Sie dazu wie folgt vor:

- Öffnen Sie die Windows-Einstellungen und suchen Sie nach

Umgebungsvariablen. - Klicken Sie auf

Umgebungsvariablen für Ihr Konto bearbeiten. - Erstellen Sie eine neue Variable oder bearbeiten Sie eine ggf. vorhandene Variable mit dem Namen

OLLAMA_MODELS. - Setzen Sie den Wert auf den gewünschten Speicherort für die Modelle (z. B.

D:\OllamaModels\). - Klicken Sie auf

OKoderAnwenden, um die Änderungen zu speichern. - Beenden Sie die Ollama-Anwendung (falls diese bereits läuft) und starten Sie sie neu über das Startmenü oder ein neues Terminal.

3. Netzwerkzugriff aktivieren

Um Ollama aus dem gesamten Netzwerk ansprechen zu können, müssen Sie auch noch analog die Umgebungsvariable OLLAMA_HOST auf den Wert 0.0.0.0 setzen. Gehen Sie dazu wie folgt vor:

- Öffnen Sie die Windows-Einstellungen und suchen Sie nach

Umgebungsvariablen. - Klicken Sie auf

Umgebungsvariablen für Ihr Konto bearbeiten. - Erstellen Sie eine neue Variable oder bearbeiten Sie eine ggf. vorhandene Variable mit dem Namen

OLLAMA_HOST. - Setzen Sie den Wert auf

0.0.0.0. - Klicken Sie auf

OKoderAnwenden, um die Änderungen zu speichern. - Beenden Sie die Ollama-Anwendung (falls diese bereits läuft) und starten Sie sie neu über das Startmenü oder ein neues Terminal.

4. Kommandozeile öffnen

Unter Windows 10 drücken Sie die Tastenkombination Windows-Taste + R, geben Sie cmd ein und drücken Sie Enter, unter Windows 11 klicken Sie mit der rechten Maustaste auf das Startmenü und wählen Terminal oder Eingabeaufforderung.

5. Geeignetes Modell auswählen

(siehe Tabelle oben)

6. Modelle herunterladen und installieren

In der Kommandozeile können Sie ein Modell mit folgendem Befehl starten:

ollama pull <Modellname>

Beispiel:

ollama pull gemma2:9b

Das Modell wird heruntergeladen und ist nach Abschluss des Downloads einsatzbereit.

(Optional für Administratoren) Ollama alternativ direkt mit PowerShell verwenden

1. PowerShell starten

Unter Windows 10 drücken Sie die Tastenkombination Windows-Taste + R, geben den Befehl powershell ein und drücken Enter Unter Windows 11 klicken Sie mit der rechten Maustaste auf das Startmenü und wählen PowerShell oder Windows Terminal (falls PowerShell als Standardshell eingestellt ist).

2. Beispielbefehl ausführen

Führen Sie den folgenden Befehl in der PowerShell aus, um einen direkten API-Zugriff zu testen:

(Invoke-WebRequest -method POST -Body '{"model":"llama3.2", "prompt":"Why is the sky blue?", "stream": false}' -uri http://localhost:11434/api/generate ).Content | ConvertFrom-json

3. Ergebnisse überprüfen

Der Befehl sendet eine Anfrage an den lokalen Ollama-Server und gibt die Antwort im JSON-Format zurück.

Hinweis: Stellen Sie sicher, dass der Ollama-Server läuft, bevor Sie den Befehl ausführen. Falls er nicht läuft, starten Sie die Anwendung über das Startmenü oder ein Terminal.

Allgemeine Hinweise

-

Es gibt so etwas wie einen „Warmup“, d. h. eine Aufwärmzeit. Der allererste Aufruf mit demselben Modell ist noch deutlich langsamer als nachfolgende Aufrufe (Cache).

-

Wenn der PC auf einen Neustart für Windows-Updates wartet, ist Ollama ggf. nicht erreichbar. Nach der Installation der Windows-Updates und dem Neustart funktioniert dann alles wieder wie gewohnt.

-

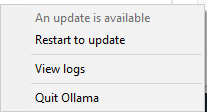

Es gibt regelmäßig neue Versionen von Ollama, die nicht automatisch installiert werden, aber oft Voraussetzung für den Betrieb neuer Modelle sind. Wichtige Updates werden per Newsletter angekündigt, der unten auf der Seite abonniert werden kann: Download Ollama on macOS

Alternativ sieht man an einem blauen Punkt auf dem Ollama-Symbol, dass es ein Update gibt. Dieses kann interaktiv mit Rechtsklick und der Auswahl Restart to Update installiert werden.

Weiterführende Links

FAQ von Ollama: https://docs.ollama.com/faq

Inoffizielle FAQ: GitHub - maglore9900/personal_Ollama_FAQ

Beispiele für aktuell verfügbare Nvidia 3060-Karten mit 12 GB VRAM:

https://www.amazon.de/Gigabyte-V2-Grafikkarte-GV-N3060GAMING-OC-12GD/dp/B096Y2TYKV/?th=1

https://www.amazon.de/ASUS-Grafikkarte-Speicher-DisplayPort-DUAL-RTX3060-O12G-V2/dp/B096658ZWP/?th=1

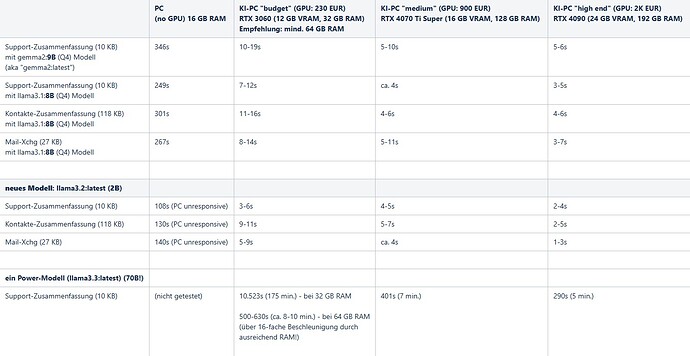

Beispielwerte in unseren Messungen

Je nach der konkreten Konfiguration (CPU, Motherboard, RAM, Variante der Grafikkarte) können die Werte natürlich abweichen. Die folgenden Daten sind nur als Anhaltspunkte zu verstehen und stellen keine Zusicherung dar.

Disclaimer

combit macht keine Angaben zu einer bestimmten Eignung obiger Informationen. Irrtümer und Fehler bleiben ausdrücklich vorbehalten, die Angaben erfolgen ohne Gewähr und enthalten keine Zusicherung. Die Angaben stellen nur Beschreibungen dar und enthalten keine Garantie der Beschaffenheit der Produkte. Die Informationen können z. T. auch ein Versuch sein, Ihnen bei einer Aufgabenstellung zu helfen, selbst wenn das Produkt eigentlich nicht für diesen speziellen Zweck vorgesehen wurde. Alle genannten Produkte und Produktbezeichnungen sowie Logos sind Marken, eingetragene Warenzeichen oder Eigentum der jeweiligen Hersteller.